Upload folder using huggingface_hub

Browse files- .gitattributes +1 -0

- README.md +525 -0

- added_tokens.json +16 -0

- chat_template.json +3 -0

- config.json +48 -0

- generation_config.json +14 -0

- images/27vid-Gaza-City-Cover-gqmt-videoSixteenByNine1050 (1).jpg +0 -0

- images/nguyentonnhuan.jpg +0 -0

- images/nguyenvandung_back.png +0 -0

- images/nguyenvandung_front.png +0 -0

- images/test.txt +0 -0

- images/trinhquangduy_back.jpg +0 -0

- images/trinhquangduy_front.jpg +0 -0

- merges.txt +0 -0

- openvino_language_model.bin +3 -0

- openvino_language_model.xml +0 -0

- openvino_text_embeddings_model.bin +3 -0

- openvino_text_embeddings_model.xml +107 -0

- openvino_vision_embeddings_merger_model.bin +3 -0

- openvino_vision_embeddings_merger_model.xml +0 -0

- openvino_vision_embeddings_model.bin +3 -0

- openvino_vision_embeddings_model.xml +167 -0

- preprocessor_config.json +29 -0

- special_tokens_map.json +31 -0

- tokenizer.json +3 -0

- tokenizer_config.json +145 -0

- vocab.json +0 -0

.gitattributes

CHANGED

|

@@ -33,3 +33,4 @@ saved_model/**/* filter=lfs diff=lfs merge=lfs -text

|

|

| 33 |

*.zip filter=lfs diff=lfs merge=lfs -text

|

| 34 |

*.zst filter=lfs diff=lfs merge=lfs -text

|

| 35 |

*tfevents* filter=lfs diff=lfs merge=lfs -text

|

|

|

|

|

|

| 33 |

*.zip filter=lfs diff=lfs merge=lfs -text

|

| 34 |

*.zst filter=lfs diff=lfs merge=lfs -text

|

| 35 |

*tfevents* filter=lfs diff=lfs merge=lfs -text

|

| 36 |

+

tokenizer.json filter=lfs diff=lfs merge=lfs -text

|

README.md

ADDED

|

@@ -0,0 +1,525 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

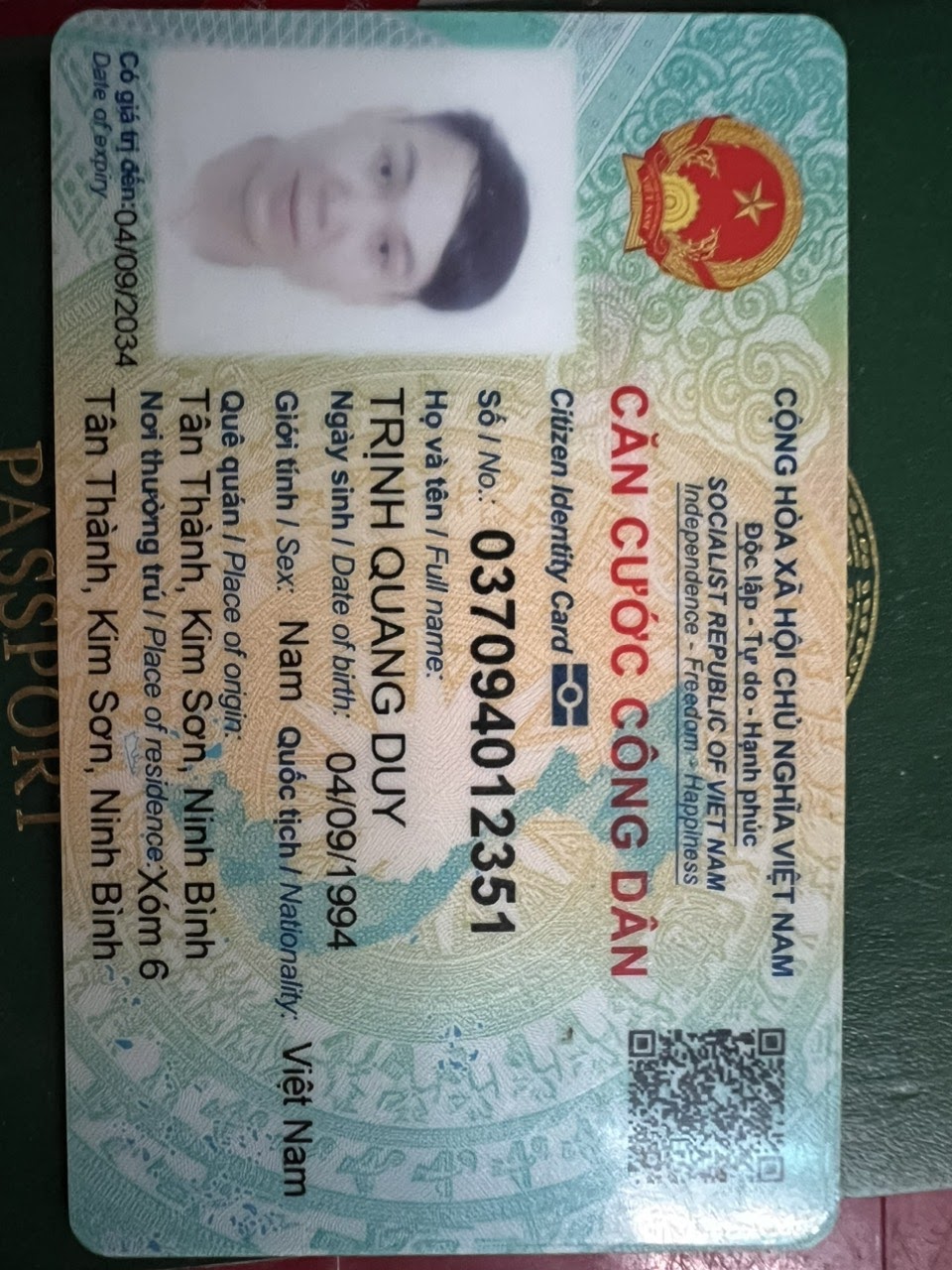

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

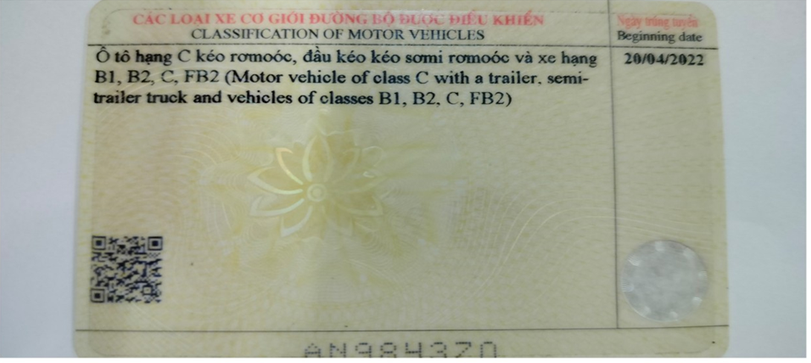

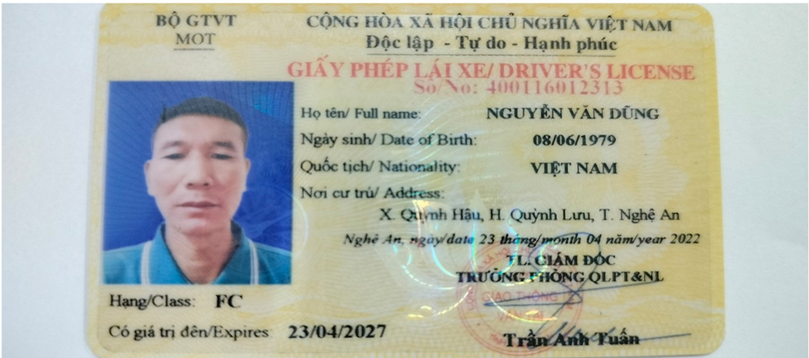

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1 |

+

---

|

| 2 |

+

license: apache-2.0

|

| 3 |

+

language:

|

| 4 |

+

- vi

|

| 5 |

+

- en

|

| 6 |

+

- zh

|

| 7 |

+

base_model:

|

| 8 |

+

- Qwen/Qwen2-VL-2B-Instruct

|

| 9 |

+

library_name: transformers

|

| 10 |

+

tags:

|

| 11 |

+

- erax

|

| 12 |

+

- multimodal

|

| 13 |

+

- erax-vl-2B

|

| 14 |

+

- insurance

|

| 15 |

+

- ocr

|

| 16 |

+

- vietnamese

|

| 17 |

+

- bcg

|

| 18 |

+

pipeline_tag: visual-question-answering

|

| 19 |

+

|

| 20 |

+

widget:

|

| 21 |

+

- src: images/photo-1-16505057982762025719470.webp

|

| 22 |

+

example_title: Test 1

|

| 23 |

+

- src: images/vt-don-thuoc-f0-7417.jpeg

|

| 24 |

+

example_title: Test 2

|

| 25 |

+

---

|

| 26 |

+

<p align="left">

|

| 27 |

+

<img src="https://cdn-uploads.huggingface.co/production/uploads/63d8d8879dfcfa941d4d7cd9/GsQKdaTyn2FFx_cZvVHk3.png" alt="Logo">

|

| 28 |

+

</p>

|

| 29 |

+

|

| 30 |

+

|

| 31 |

+

# EraX-VL-7B-V1.5

|

| 32 |

+

## Introduction 🎉

|

| 33 |

+

|

| 34 |

+

Hot on the heels of the popular **<a href="https://huggingface.co/erax-ai/EraX-VL-7B-V1.0" target="_blank">EraX-VL-7B-V1.0 model</a>**, we proudly present **EraX-VL-7B-V1.5**, another robust multimodal model for **OCR (optical character recognition)** and **VQA (visual question-answering)** that excels in various languages 🌍, with a particular focus on Vietnamese 🇻🇳. This model stands out for its precise recognition capabilities across a range of documents 📝, including medical forms 🩺, invoices 🧾, bills of sale 💳, quotes 📄, and medical records 💊. This functionality is expected to be highly beneficial for hospitals 🏥, clinics 💉, insurance companies 🛡️, and other similar applications 📋. Built on the solid foundation of the [Qwen/Qwen2-VL-2B-Instruct](https://huggingface.co/Qwen/Qwen2-VL-7B-Instruct)[1], which we found to be of high quality and fluent in Vietnamese, `EraX-VL-7B-V1.5` has been fine-tuned to enhance its performance. We plan to continue improving and releasing new versions for free, along with sharing performance benchmarks in the near future.

|

| 35 |

+

|

| 36 |

+

One standing-out feature of **EraX-VL-7B-V1.5** is the capability to do multi-turn Q&A with impressive reasoning capability!

|

| 37 |

+

|

| 38 |

+

**NOTA BENE**:

|

| 39 |

+

- EraX-VL-7B-V1.5 is NOT a typical OCR-only tool likes Tesseract but is a Multimodal LLM-based model. To use it effectively, you may have to **twist your prompt carefully** depending on your tasks.

|

| 40 |

+

- This model was NOT finetuned with medical (X-ray) dataset or car accidences (yet). Stay tune for updated version coming up sometime early 2025.

|

| 41 |

+

|

| 42 |

+

**EraX-VL-7B-V1.5** is a young member of our **EraX's LànhGPT** collection of LLM models.

|

| 43 |

+

|

| 44 |

+

- **Developed by:**

|

| 45 |

+

- Nguyễn Anh Nguyên (nguyen@erax.ai)

|

| 46 |

+

- Nguyễn Hồ Nam (BCG)

|

| 47 |

+

- Phạm Huỳnh Nhật (nhat.ph@erax.ai)

|

| 48 |

+

- Phạm Đình Thục (thuc.pd@erax.ai)

|

| 49 |

+

- **Funded by:** [Bamboo Capital Group](https://bamboocap.com.vn) and EraX

|

| 50 |

+

- **Model type:** Multimodal Transformer with over 7B parameters

|

| 51 |

+

- **Languages (NLP):** Primarily Vietnamese with multilingual capabilities

|

| 52 |

+

- **License:** Apache 2.0

|

| 53 |

+

- **Fine-tuned from:** [Qwen/Qwen2-VL-7B-Instruct](https://huggingface.co/Qwen/Qwen2-VL-7B-Instruct)

|

| 54 |

+

- **Prompt examples:** <a href="https://github.com/EraX-JS-Company/erax-vl-7b-v1/blob/main/prompts/Vietnam_popular_prompts.txt" target="_blank">Some popular prompt examples on Github.</a>

|

| 55 |

+

|

| 56 |

+

## Benchmarks 📊

|

| 57 |

+

|

| 58 |

+

## 🏆 LeaderBoard

|

| 59 |

+

|

| 60 |

+

The EraX-VL-7B-V1.5 achieved exceptionally high performance compared to other models of equal size or even **10 times larger, and we open-source**! You can re-run the benchmark at any time.

|

| 61 |

+

|

| 62 |

+

<table style="width:75%;">

|

| 63 |

+

<tr>

|

| 64 |

+

<th align="middle" width="300">Models</th>

|

| 65 |

+

<td align="middle" width="150"><b>Open-Source</b></td>

|

| 66 |

+

<td align="middle" width="300"><b>VI-MTVQA</b></td>

|

| 67 |

+

</tr>

|

| 68 |

+

<tr>

|

| 69 |

+

<th align="middle"><font color=darkred>EraX-VL-7B-V1.5 🥇 </font></th>

|

| 70 |

+

<td align="middle">✅</td>

|

| 71 |

+

<td align="middle">47.2 </td>

|

| 72 |

+

</tr>

|

| 73 |

+

<tr>

|

| 74 |

+

<th align="middle">Qwen2-VL 72B 🥈 </th>

|

| 75 |

+

<td align="middle">✘</td>

|

| 76 |

+

<td align="middle">41.6 </td>

|

| 77 |

+

</tr>

|

| 78 |

+

<tr>

|

| 79 |

+

<th align="middle">ViGPT-VL 🥉 </th>

|

| 80 |

+

<td align="middle">✘</td>

|

| 81 |

+

<td align="middle">39.1 </td>

|

| 82 |

+

</tr>

|

| 83 |

+

<tr>

|

| 84 |

+

<th align="middle"><font color=darkred>EraX-VL-2B-V1.5</font></th>

|

| 85 |

+

<td align="middle"> ✅ </td>

|

| 86 |

+

<td align="middle">38.2 </td>

|

| 87 |

+

</tr>

|

| 88 |

+

<tr>

|

| 89 |

+

<th align="middle"><font color=darkred>EraX-VL-7B-V1 </font></th>

|

| 90 |

+

<td align="middle"> ✅ </td>

|

| 91 |

+

<td align="middle">37.6 </td>

|

| 92 |

+

</tr>

|

| 93 |

+

<tr>

|

| 94 |

+

<th align="middle"><font color=darkred>Vintern-1B-V2</font></th>

|

| 95 |

+

<td align="middle"> ✅ </td>

|

| 96 |

+

<td align="middle">37.4 </td>

|

| 97 |

+

</tr>

|

| 98 |

+

<tr>

|

| 99 |

+

<th align="middle"><font color=darkred>Qwen2-VL 7B </font></th>

|

| 100 |

+

<td align="middle"> ✅ </td>

|

| 101 |

+

<td align="middle">30.0 </td>

|

| 102 |

+

</tr>

|

| 103 |

+

<tr>

|

| 104 |

+

<th align="middle">Claude3 Opus</th>

|

| 105 |

+

<td align="middle">✘</td>

|

| 106 |

+

<td align="middle">29.1 </td>

|

| 107 |

+

</tr>

|

| 108 |

+

<tr>

|

| 109 |

+

<th align="middle">GPT-4o mini </th>

|

| 110 |

+

<td align="middle"> ✘ </td>

|

| 111 |

+

<td align="middle">29.1 </td>

|

| 112 |

+

</tr>

|

| 113 |

+

<tr>

|

| 114 |

+

<th align="middle">GPT-4V</th>

|

| 115 |

+

<td align="middle">✘</td>

|

| 116 |

+

<td align="middle">28.9 </td>

|

| 117 |

+

</tr>

|

| 118 |

+

<tr>

|

| 119 |

+

<th align="middle">Gemini Ultra</th>

|

| 120 |

+

<td align="middle">✘</td>

|

| 121 |

+

<td align="middle">28.6 </td>

|

| 122 |

+

</tr>

|

| 123 |

+

<tr>

|

| 124 |

+

<th align="middle"><font color=darkred>InternVL2 76B</font></th>

|

| 125 |

+

<td align="middle"> ✅ </td>

|

| 126 |

+

<td align="middle">26.9 </td>

|

| 127 |

+

</tr>

|

| 128 |

+

<tr>

|

| 129 |

+

<th align="middle">QwenVL Max</th>

|

| 130 |

+

<td align="middle">✘</td>

|

| 131 |

+

<td align="middle">23.5 </td>

|

| 132 |

+

</tr>

|

| 133 |

+

<tr>

|

| 134 |

+

<th align="middle">Claude3 Sonnet</th>

|

| 135 |

+

<td align="middle">✘</td>

|

| 136 |

+

<td align="middle">20.8 </td>

|

| 137 |

+

</tr>

|

| 138 |

+

<tr>

|

| 139 |

+

<th align="middle">QwenVL Plus</th>

|

| 140 |

+

<td align="middle">✘</td>

|

| 141 |

+

<td align="middle">18.1 </td>

|

| 142 |

+

</tr>

|

| 143 |

+

<tr>

|

| 144 |

+

<th align="middle"><font color=darkred>MiniCPM-V2.5</font></th>

|

| 145 |

+

<td align="middle">✅</td>

|

| 146 |

+

<td align="middle">15.3 </td>

|

| 147 |

+

</tr>

|

| 148 |

+

</table>

|

| 149 |

+

|

| 150 |

+

**The test code for evaluating models in the paper can be found in**: <b><a href="https://github.com/EraX-JS-Company/EraX-MTVQA-Benchmark" target="_blank">EraX-JS-Company/EraX-MTVQA-Benchmark</a></b>

|

| 151 |

+

|

| 152 |

+

## API trial 🎉

|

| 153 |

+

Please contact **nguyen@erax.ai** for API access inquiry.

|

| 154 |

+

|

| 155 |

+

## Examples 🧩

|

| 156 |

+

|

| 157 |

+

### 1. OCR - Optical Character Recognition for Multi-Images

|

| 158 |

+

|

| 159 |

+

**Example 01: Citizen identification card**

|

| 160 |

+

|

| 161 |

+

<div style="display: flex; flex-direction: row; align-items: center; justify-content: center;">

|

| 162 |

+

<div style="text-align: center; margin: 0 10px;">

|

| 163 |

+

<img src="images/trinhquangduy_front.jpg" width="500" alt="Front View" />

|

| 164 |

+

<p>Front View</p>

|

| 165 |

+

</div>

|

| 166 |

+

<div style="text-align: center; margin: 0 10px;">

|

| 167 |

+

<img src="images/trinhquangduy_back.jpg" width="500" alt="Back View" />

|

| 168 |

+

<p>Back View</p>

|

| 169 |

+

</div>

|

| 170 |

+

</div>

|

| 171 |

+

<p style="text-align: center; font-size: 12px; color: gray; margin-top: 10px;">

|

| 172 |

+

Source: <a href="https://support.google.com/google-ads/thread/270967947/t%C3%B4i-%C4%91%C3%A3-g%E1%BB%ADi-h%C3%ACnh-%E1%BA%A3nh-c%C4%83n-c%C6%B0%E1%BB%9Bc-c%C3%B4ng-d%C3%A2n-c%E1%BB%A7a-ch%C3%ADnh-t%C3%B4i-%C4%91%E1%BB%83-x%C3%A1c-minh-danh-t%C3%ADnh?hl=vi" target="_blank">Google Support</a>

|

| 173 |

+

</p>

|

| 174 |

+

|

| 175 |

+

```

|

| 176 |

+

{

|

| 177 |

+

"Số thẻ": "037094012351",

|

| 178 |

+

"Họ và tên": "TRỊNH QUANG DUY",

|

| 179 |

+

"Ngày sinh": "04/09/1994",

|

| 180 |

+

"Giới tính": "Nam",

|

| 181 |

+

"Quốc tịch": "Việt Nam",

|

| 182 |

+

"Quê quán": "Tân Thành, Kim Sơn, Ninh Bình",

|

| 183 |

+

"Nơi thường trú": "Xóm 6\nTân Thành, Kim Sơn, Ninh Bình",

|

| 184 |

+

"Có giá trị đến": "04/09/2034",

|

| 185 |

+

"Đặc điểm nhân dạng": "sẹo chấm c. 1cm trên đuôi mắt trái",

|

| 186 |

+

"Nơi cấp": "CỤC TRƯỞNG CỤC CẢNH SÁT\nQUẢN LÝ HÀNH CHÍNH VỀ TRẬT TỰ XÃ HỘI",

|

| 187 |

+

"Ngày cấp": "10/12/2022",

|

| 188 |

+

"Cán bộ ký tên": "Nguyễn Quốc Hùng",

|

| 189 |

+

"Mã định danh": "IDVNM0940123513037094012351"

|

| 190 |

+

}

|

| 191 |

+

```

|

| 192 |

+

|

| 193 |

+

**Example 02: Driver's License**

|

| 194 |

+

|

| 195 |

+

<div style="display: flex; flex-direction: row; align-items: center; justify-content: center;">

|

| 196 |

+

<div style="text-align: center; margin: 0 10px;">

|

| 197 |

+

<img src="images/nguyenvandung_front.png" width="500" alt="Front View" />

|

| 198 |

+

<p>Front View</p>

|

| 199 |

+

</div>

|

| 200 |

+

<div style="text-align: center; margin: 0 10px;">

|

| 201 |

+

<img src="images/nguyenvandung_back.png" width="500" alt="Back View" />

|

| 202 |

+

<p>Back View</p>

|

| 203 |

+

</div>

|

| 204 |

+

</div>

|

| 205 |

+

<p style="text-align: center; font-size: 12px; color: gray; margin-top: 10px;">

|

| 206 |

+

Source: <a href="https://baophapluat.vn/khoi-to-tai-xe-len-mang-mua-giay-phep-lai-xe-gia-de-chay-xe-post481047.html" target="_blank">Báo Pháp luật</a>

|

| 207 |

+

</p>

|

| 208 |

+

|

| 209 |

+

```

|

| 210 |

+

{

|

| 211 |

+

"No.":"400116012313"

|

| 212 |

+

"Fullname":"NGUYỄN VĂN DŨNG"

|

| 213 |

+

"Date_of_birth":"08/06/1979"

|

| 214 |

+

"Nationality":"VIỆT NAM"

|

| 215 |

+

"Address":"X. Quỳnh Hầu, H. Quỳnh Lưu, T. Nghệ An

|

| 216 |

+

Nghệ An, ngày/date 23 tháng/month 04 năm/year 2022"

|

| 217 |

+

"Hang_Class":"FC"

|

| 218 |

+

"Expires":"23/04/2027"

|

| 219 |

+

"Place_of_issue":"Nghệ An"

|

| 220 |

+

"Date_of_issue":"ngày/date 23 tháng/month 04 năm/year 2022"

|

| 221 |

+

"Signer":"Trần Anh Tuấn"

|

| 222 |

+

"Các loại xe được phép":"Ô tô hạng C kéo rơmoóc, đầu kéo kéo sơmi rơmoóc và xe hạng B1, B2, C, FB2 (Motor vehicle of class C with a trailer, semi-trailer truck and vehicles of classes B1, B2, C, FB2)"

|

| 223 |

+

"Mã số":""

|

| 224 |

+

}

|

| 225 |

+

```

|

| 226 |

+

|

| 227 |

+

**Example 03: Vehicle Registration Certificate**

|

| 228 |

+

|

| 229 |

+

<div style="display: flex; flex-direction: row; align-items: center; justify-content: center;">

|

| 230 |

+

<div style="text-align: center; margin: 0 10px;">

|

| 231 |

+

<img src="images/nguyentonnhuan.jpg" width="700"/>

|

| 232 |

+

</div>

|

| 233 |

+

</div>

|

| 234 |

+

<p style="text-align: center; font-size: 12px; color: gray; margin-top: 10px;">

|

| 235 |

+

Source: <a href="https://vietnamnet.vn/phan-biet-cac-loai-giay-dang-ky-xe-khi-mua-moto-da-qua-su-dung-541341.html" target="_blank">Báo Vietnamnet</a>

|

| 236 |

+

</p>

|

| 237 |

+

|

| 238 |

+

```

|

| 239 |

+

{

|

| 240 |

+

"Tên chủ xe": "NGUYỄN TÔN NHUẬN",

|

| 241 |

+

"Địa chỉ": "KE27 Kp3 P.TTTây Q7",

|

| 242 |

+

"Nhãn hiệu": "HONDA",

|

| 243 |

+

"Số loại": "DYLAN",

|

| 244 |

+

"Màu sơn": "Trắng",

|

| 245 |

+

"Năm sản xuất": "2012",

|

| 246 |

+

"Số máy": "F03E-0057735",

|

| 247 |

+

"Số khung": "SA04F-070410",

|

| 248 |

+

"Dung tích": "152",

|

| 249 |

+

"Số chỗ ngồi": "02",

|

| 250 |

+

"Biển số đăng ký": "59V1-498.89",

|

| 251 |

+

"Đăng ký lần đầu ngày": "08/06/2004",

|

| 252 |

+

"Chức vụ": "Thượng tá",

|

| 253 |

+

"Người ký": "Trần Văn Hiểu"

|

| 254 |

+

}

|

| 255 |

+

```

|

| 256 |

+

|

| 257 |

+

**Example 04: Vehicle Registration**

|

| 258 |

+

|

| 259 |

+

<div style="display: flex; flex-direction: row; align-items: center; justify-content: center;">

|

| 260 |

+

<div style="text-align: center; margin: 10 20px;">

|

| 261 |

+

<img src="https://cdn-uploads.huggingface.co/production/uploads/63d8d8879dfcfa941d4d7cd9/w5WCaQ-k9nupRIQYddcpr.jpeg" width="700"/>

|

| 262 |

+

</div>

|

| 263 |

+

</div>

|

| 264 |

+

<p style="text-align: center; font-size: 12px; color: gray; margin-top: 10px;">

|

| 265 |

+

Source: <a href="https://llumar.com.vn/dang-kiem-xe-o-to/" target="_blank">https://llumar.com.vn</a>

|

| 266 |

+

</p>

|

| 267 |

+

|

| 268 |

+

```

|

| 269 |

+

{

|

| 270 |

+

"vehicle": {

|

| 271 |

+

"registration_number": "30A-072.36",

|

| 272 |

+

"vehicle_inspection_number": "2903V-093515",

|

| 273 |

+

"type": "ô tô con",

|

| 274 |

+

"mark": "MERCEDES-BENZ",

|

| 275 |

+

"model_code": "C300 W204",

|

| 276 |

+

"engine_number": "27294732096079",

|

| 277 |

+

"chassis_number": "RLMGF5EX3DV005333",

|

| 278 |

+

"manufactured_year_and_country": "2013, Việt Nam",

|

| 279 |

+

"life_time_limit_to": "",

|

| 280 |

+

"commercial_use": "",

|

| 281 |

+

"modification": ""

|

| 282 |

+

},

|

| 283 |

+

"specifications": {

|

| 284 |

+

"wheel_formula": "4x2",

|

| 285 |

+

"wheel_tread": "1521/1512 (mm)",

|

| 286 |

+

"overall_dimension": "4650 x 1770 x 1429 (mm)",

|

| 287 |

+

"largest_luggage_container_dimension": "",

|

| 288 |

+

"wheelbase": "2760 (mm)",

|

| 289 |

+

"kerb_mass": "1575 (kg)",

|

| 290 |

+

"design_authorized_pay_load": "",

|

| 291 |

+

"design_authorized_total_mass": "2090/2090 (kg)",

|

| 292 |

+

"design_authorized_towed_mass": "",

|

| 293 |

+

"permissible_number_of_pers_carried": "5 chỗ ngồi, 0 chỗ đứng, 0 chỗ nằm",

|

| 294 |

+

"type_of_fuel_used": "Xăng",

|

| 295 |

+

"engine_displacement": "2996 (cm3)",

|

| 296 |

+

"max_output_per_rpm": "170(kW)/6000vph",

|

| 297 |

+

"number": "KC-1292285"

|

| 298 |

+

},

|

| 299 |

+

"inspection_report_number": "2905V-20953/16",

|

| 300 |

+

"valid_until": "31/01/2018",

|

| 301 |

+

"place_date_of_issue": "Hà Nội, ngày 1 tháng 8 năm 2016",

|

| 302 |

+

"inspection_center": "ĐƠN VỊ KIỂM ĐỊNH XE CƠ GIỚI",

|

| 303 |

+

"signature": "Ngọc Tuấn",

|

| 304 |

+

"equipped_with_tachograph": "",

|

| 305 |

+

"inspection_stamp_was_not_issued": "",

|

| 306 |

+

"notes": "Biển đăng ký nền trắng"

|

| 307 |

+

}

|

| 308 |

+

```

|

| 309 |

+

|

| 310 |

+

**Example 05: Receipt**

|

| 311 |

+

|

| 312 |

+

<div style="display: flex; flex-direction: row; align-items: center; justify-content: center;">

|

| 313 |

+

<div style="text-align: center; margin: 10 20px;">

|

| 314 |

+

<img src="https://cdn-uploads.huggingface.co/production/uploads/63d8d8879dfcfa941d4d7cd9/40vIbNdM1cFXwQYNHx7Ag.jpeg" width="500"/>

|

| 315 |

+

</div>

|

| 316 |

+

</div>

|

| 317 |

+

<p style="text-align: center; font-size: 12px; color: gray; margin-top: 10px;">

|

| 318 |

+

Source: <a href="https://tintucketoan.com/cach-viet-hoa-don-hang-hoa-dich-vu-khong-chiu-thue-gtgt/" target="_blank">https://tintucketoan.com/</a>

|

| 319 |

+

</p>

|

| 320 |

+

|

| 321 |

+

```

|

| 322 |

+

{

|

| 323 |

+

'Mẫu số': '01GKTKT3/001',

|

| 324 |

+

'Ký hiệu': 'TC/18P',

|

| 325 |

+

'Số': '0000030',

|

| 326 |

+

'Họ tên người mua hàng': None,

|

| 327 |

+

'Tên đơn vị': 'Công Ty TNHH Kế Toán Hà Nội',

|

| 328 |

+

'Mã số thuế': '0106235869',

|

| 329 |

+

'Địa chỉ': 'Số 49 Ngõ 322 Lê Trọng Tấn, phường Khương Mai, quận Thanh Xuân, Hà Nội',

|

| 330 |

+

'Hình thức thanh toán': 'TM',

|

| 331 |

+

'STT': None,

|

| 332 |

+

'Tên hàng hóa, dịch vụ': 'Tra cứu phần mềm thư viện pháp luật trực tuyến',

|

| 333 |

+

'Đơn vị tính': None,

|

| 334 |

+

'Số lượng': None,

|

| 335 |

+

'Đơn giá': '168.000',

|

| 336 |

+

'Thành tiền': '2.016.000',

|

| 337 |

+

'Thuế suất GTGT': None,

|

| 338 |

+

'Tiền thuế GTGT': None,

|

| 339 |

+

'Tổng cộng tiền thanh toán': '2.016.000',

|

| 340 |

+

'Số tiền viết bằng chữ': 'Hai triệu, không trăm mười sáu nghìn đồng',

|

| 341 |

+

'Người bán hàng': 'Bùi Văn Hùng',

|

| 342 |

+

'Chức vụ người bán hàng': 'TRƯỞNG CHI NHÁNH'

|

| 343 |

+

}

|

| 344 |

+

```

|

| 345 |

+

|

| 346 |

+

### 2.1 Image Captioning

|

| 347 |

+

|

| 348 |

+

<div align="center">

|

| 349 |

+

<img src="https://cdn-uploads.huggingface.co/production/uploads/63d8d8879dfcfa941d4d7cd9/g5V60A7rI94TH0z3zdSAA.jpeg" width="700"/>

|

| 350 |

+

</div>

|

| 351 |

+

|

| 352 |

+

Hình ảnh là biểu đồ BMI theo tuổi, thể hiện mối quan hệ giữa chỉ số khối cơ thể (BMI) và độ tuổi của trẻ em. Biểu đồ được chia thành các vùng màu khác nhau tương ứng với các mức BMI khác nhau:

|

| 353 |

+

|

| 354 |

+

* **Vùng màu đỏ:** Chỉ số BMI cao hơn 25, cho thấy tình trạng béo phì.

|

| 355 |

+

* **Vùng màu vàng:** Chỉ số BMI nằm trong khoảng từ 18 đến 25, cho thấy nguy cơ béo phì.

|

| 356 |

+

* **Vùng màu xanh lá cây nhạt:** Chỉ số BMI nằm trong khoảng từ 16 đến 18, cho thấy sức khỏe dinh dưỡng tốt.

|

| 357 |

+

* **Vùng màu xanh lá cây đậm:** Chỉ số BMI thấp hơn 16, cho thấy tình trạng thiếu cân.

|

| 358 |

+

|

| 359 |

+

Trục tung biểu diễn chỉ số BMI, trục hoành biểu diễn tuổi (tính bằng năm). Đường cong màu xám đậm thể hiện đường chuẩn BMI theo tuổi. Các đường cong này cho thấy sự thay đổi BMI theo thời gian, giúp đánh giá sự phát triển cân nặng của trẻ em. Ví dụ, ở trẻ em dưới 3 tuổi, BMI thường dao động trong vùng thiếu cân hoặc sức khỏe dinh dưỡng tốt. Khi trẻ lớn lên, BMI có xu hướng tăng dần, nhưng tốc độ tăng trưởng có thể khác nhau tùy thuộc vào từng cá nhân. Biểu đồ cũng hiển thị các phần trăm phân vị (Percentile), cho biết tỷ lệ phần trăm trẻ em có BMI thấp hơn hoặc cao hơn so với một nhóm trẻ em cùng độ tuổi. Điều này giúp so sánh BMI của trẻ em với tiêu chuẩn quốc tế.

|

| 360 |

+

|

| 361 |

+

### 2.2 Image Captioning

|

| 362 |

+

|

| 363 |

+

<div align="center">

|

| 364 |

+

<img src="https://huggingface.co/erax-ai/EraX-VL-7B-V1.5/resolve/main/images/27vid-Gaza-City-Cover-gqmt-videoSixteenByNine1050%20(1).jpg" width="700"/>

|

| 365 |

+

</div>

|

| 366 |

+

|

| 367 |

+

Hình ảnh chụp một cảnh tượng đầy xúc động và bi thảm, dường như diễn ra ở một khu vực nghèo khó, có thể là một khu định cư hoặc khu ổ chuột. Trung tâm của bức ảnh là một chiếc xe đẩy được kéo bởi một con lừa. Trên xe đẩy có một nhóm người, bao gồm một người đàn ông lớn tuổi có vẻ như là người hướng dẫn, một phụ nữ mặc áo choàng đen, một phụ nữ trẻ mặc áo xám, một bé gái nhỏ được che mặt bằng khăn trùm đầu, và một cậu bé mặc áo xanh lá cây. Họ có vẻ như đang di chuyển từ một khu vực bị tàn phá sang một nơi khác. Xung quanh họ là những mảnh vụn, rác thải và những tòa nhà đổ nát, cho thấy một môi trường sống khó khăn và thiếu thốn. Phía sau họ, có một số người khác đang đi bộ hoặc đi xe đạp, một số người đang mang theo hành lý. Bầu trời trong xanh, nhưng không khí chung của bức ảnh là nặng nề và buồn bã. Có thể đây là một cảnh tượng di cư, tị nạn, hoặc một sự kiện thảm khốc nào đó.

|

| 368 |

+

|

| 369 |

+

### 3. Multi-turns Visual Question Answering and Reasoning

|

| 370 |

+

|

| 371 |

+

<div style="display: flex; flex-direction: row; align-items: center; justify-content: center;">

|

| 372 |

+

<div style="text-align: center; margin: 10 20px;">

|

| 373 |

+

<img src="https://cdn-uploads.huggingface.co/production/uploads/63d8d8879dfcfa941d4d7cd9/S2UosY_TOOV5XNn3d4_zL.jpeg" width="700"/>

|

| 374 |

+

</div>

|

| 375 |

+

</div>

|

| 376 |

+

<p style="text-align: center; font-size: 12px; color: gray; margin-top: 10px;">

|

| 377 |

+

Source: <a href="https://kenh14.vn/bien-cang-thai-trinh-nhap-vien-vi-ngo-doc-dang-dan-to-1-resort-5-sao-thieu-trach-nhiem-voi-khach-hang-20200924214133912.chn" target="_blank">https://kenh14.vn</a>

|

| 378 |

+

</p>

|

| 379 |

+

|

| 380 |

+

- **User**: Hãy cho biết thông tin bệnh nhân

|

| 381 |

+

|

| 382 |

+

- **Assistant**: Tên: NGUYỄN THỊ THÁI TRINH, Ngày sinh: 09/09/1993, Giới tính: Nữ, Địa chỉ: TÂN ĐỊNH - Q1 - TPHCM, Mã thẻ BHYT: 19169080, Số khám bệnh: 2569501, Mã khu vực (K1/K2/K3): 2

|

| 383 |

+

|

| 384 |

+

- **User**: Họ được chuẩn đoán bị bệnh gì?

|

| 385 |

+

|

| 386 |

+

- **Assistant**: Nhiễm trùng đường ruột do vi khuẩn, không xác định loài

|

| 387 |

+

|

| 388 |

+

- **User**: Người bệnh có tiền sử bệnh không? Nếu có thì là gì?

|

| 389 |

+

|

| 390 |

+

- **Assistant**: Thiếu Calci do chế độ ăn

|

| 391 |

+

|

| 392 |

+

- **User**: Bệnh nhân đã thực hiện những xét nghiệm gì?

|

| 393 |

+

|

| 394 |

+

- **Assistant**: [NQ286] Tổng phân tích tế bào máu ngoại vi (bằng máy đếm laser), [NQ286] Điện giải đồ (Na, K, Cl) [Máu], [NQ286] Đo hoạt độ ALT (GPT) [Máu], [NQ286] Đo hoạt độ AST (GOT) [Máu], [NQ286] Định lượng Calci toàn phần [Máu], [NQ286] Định lượng Creatinin [Máu], [NQ286] Định lượng Glucose [Máu], [NQ286] Định lượng Urê máu [Máu], [NQ286] Siêu âm ổ bụng (gan mật, tụy, lách, thận, bàng quang)

|

| 395 |

+

|

| 396 |

+

- **User**: Số tiền Vật tư y tế mà người bệnh phải trả là bao nhiêu?

|

| 397 |

+

|

| 398 |

+

- **Assistant**: 19,708

|

| 399 |

+

|

| 400 |

+

- **User**: Các loại thuốc dịch truyền người bệnh phải trả là gì, tổng số tiền là bao nhiêu?

|

| 401 |

+

|

| 402 |

+

- **Assistant**: Atropin Sulfat (Syv2019), Bicefzidim 1g (Syv2019), GONCAL (Syv2019), Lactated Ringer's-500ml (Syv2019), Nước cất pha tiêm 5ml (Syv2019), Sodium Chloride 0.9% -500ml (Syv2019), Vincomid (Syv2019), Vinopa (Syv2019), tổng cộng 45,234 đồng

|

| 403 |

+

|

| 404 |

+

## Quickstart 🎮

|

| 405 |

+

|

| 406 |

+

Install the necessary packages:

|

| 407 |

+

```curl

|

| 408 |

+

python -m pip install git+https://github.com/huggingface/transformers accelerate

|

| 409 |

+

python -m pip install qwen-vl-utils

|

| 410 |

+

pip install flash-attn --no-build-isolation

|

| 411 |

+

```

|

| 412 |

+

|

| 413 |

+

Then you can use `EraX-VL-7B-V1.5` like this:

|

| 414 |

+

```python

|

| 415 |

+

import os

|

| 416 |

+

import base64

|

| 417 |

+

import json

|

| 418 |

+

|

| 419 |

+

import cv2

|

| 420 |

+

import numpy as np

|

| 421 |

+

import matplotlib.pyplot as plt

|

| 422 |

+

|

| 423 |

+

import torch

|

| 424 |

+

from transformers import Qwen2VLForConditionalGeneration, AutoTokenizer, AutoProcessor

|

| 425 |

+

from qwen_vl_utils import process_vision_info

|

| 426 |

+

|

| 427 |

+

model_path = "erax/EraX-VL-7B-V1.5"

|

| 428 |

+

|

| 429 |

+

model = Qwen2VLForConditionalGeneration.from_pretrained(

|

| 430 |

+

model_path,

|

| 431 |

+

torch_dtype=torch.bfloat16,

|

| 432 |

+

attn_implementation="eager", # replace with "flash_attention_2" if your GPU is Ampere architecture

|

| 433 |

+

device_map="auto"

|

| 434 |

+

)

|

| 435 |

+

|

| 436 |

+

tokenizer = AutoTokenizer.from_pretrained(model_path)

|

| 437 |

+

# processor = AutoProcessor.from_pretrained(model_path)

|

| 438 |

+

|

| 439 |

+

min_pixels = 256 * 28 * 28

|

| 440 |

+

max_pixels = 1280 * 28 * 28

|

| 441 |

+

processor = AutoProcessor.from_pretrained(

|

| 442 |

+

model_path,

|

| 443 |

+

min_pixels=min_pixels,

|

| 444 |

+

max_pixels=max_pixels,

|

| 445 |

+

)

|

| 446 |

+

|

| 447 |

+

image_path ="image.jpg"

|

| 448 |

+

|

| 449 |

+

with open(image_path, "rb") as f:

|

| 450 |

+

encoded_image = base64.b64encode(f.read())

|

| 451 |

+

decoded_image_text = encoded_image.decode('utf-8')

|

| 452 |

+

base64_data = f"data:image;base64,{decoded_image_text}"

|

| 453 |

+

|

| 454 |

+

messages = [

|

| 455 |

+

{

|

| 456 |

+

"role": "user",

|

| 457 |

+

"content": [

|

| 458 |

+

{

|

| 459 |

+

"type": "image",

|

| 460 |

+

"image": base64_data,

|

| 461 |

+

},

|

| 462 |

+

{

|

| 463 |

+

"type": "text",

|

| 464 |

+

"text": "Trích xuất thông tin nội dung từ hình ảnh được cung cấp."

|

| 465 |

+

},

|

| 466 |

+

],

|

| 467 |

+

}

|

| 468 |

+

]

|

| 469 |

+

|

| 470 |

+

# Prepare prompt

|

| 471 |

+

tokenized_text = processor.apply_chat_template(

|

| 472 |

+

messages, tokenize=False, add_generation_prompt=True

|

| 473 |

+

)

|

| 474 |

+

|

| 475 |

+

image_inputs, video_inputs = process_vision_info(messages)

|

| 476 |

+

|

| 477 |

+

inputs = processor(

|

| 478 |

+

text=[ tokenized_text],

|

| 479 |

+

images=image_inputs,

|

| 480 |

+

videos=video_inputs,

|

| 481 |

+

padding=True,

|

| 482 |

+

return_tensors="pt",

|

| 483 |

+

)

|

| 484 |

+

inputs = inputs.to("cuda")

|

| 485 |

+

|

| 486 |

+

# Generation configs

|

| 487 |

+

generation_config = model.generation_config

|

| 488 |

+

generation_config.do_sample = True

|

| 489 |

+

generation_config.temperature = 1.0

|

| 490 |

+

generation_config.top_k = 1

|

| 491 |

+

generation_config.top_p = 0.9

|

| 492 |

+

generation_config.min_p = 0.1

|

| 493 |

+

generation_config.best_of = 5

|

| 494 |

+

generation_config.max_new_tokens = 2048

|

| 495 |

+

generation_config.repetition_penalty = 1.06

|

| 496 |

+

|

| 497 |

+

# Inference

|

| 498 |

+

generated_ids = model.generate(**inputs, generation_config=generation_config)

|

| 499 |

+

generated_ids_trimmed = [

|

| 500 |

+

out_ids[len(in_ids) :] for in_ids, out_ids in zip(inputs.input_ids, generated_ids)

|

| 501 |

+

]

|

| 502 |

+

output_text = processor.batch_decode(

|

| 503 |

+

generated_ids_trimmed, skip_special_tokens=True, clean_up_tokenization_spaces=False

|

| 504 |

+

)

|

| 505 |

+

|

| 506 |

+

print(output_text[0])

|

| 507 |

+

```

|

| 508 |

+

|

| 509 |

+

## References 📑

|

| 510 |

+

[1] Qwen team. Qwen2-VL. 2024.

|

| 511 |

+

|

| 512 |

+

[2] Bai, Jinze, et al. "Qwen-VL: A Versatile Vision-Language Model for Understanding, Localization, Text Reading, and Beyond." arXiv preprint arXiv:2308.12966 (2023).

|

| 513 |

+

|

| 514 |

+

[4] Yang, An, et al. "Qwen2 technical report." arXiv preprint arXiv:2407.10671 (2024).

|

| 515 |

+

|

| 516 |

+

[5] Chen, Zhe, et al. "Internvl: Scaling up vision foundation models and aligning for generic visual-linguistic tasks." Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2024.

|

| 517 |

+

|

| 518 |

+

[6] Chen, Zhe, et al. "How far are we to gpt-4v? closing the gap to commercial multimodal models with open-source suites." arXiv preprint arXiv:2404.16821 (2024).

|

| 519 |

+

|

| 520 |

+

[7] Tran, Chi, and Huong Le Thanh. "LaVy: Vietnamese Multimodal Large Language Model." arXiv preprint arXiv:2404.07922 (2024).

|

| 521 |

+

|

| 522 |

+

|

| 523 |

+

## Contact 🤝

|

| 524 |

+

- For correspondence regarding this work or inquiry for API trial, please contact Nguyễn Anh Nguyên at [nguyen@erax.ai](nguyen@erax.ai).

|

| 525 |

+

- Follow us on <b><a href="https://github.com/EraX-JS-Company" target="_blank">EraX Github</a></b>

|

added_tokens.json

ADDED

|

@@ -0,0 +1,16 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1 |

+

{

|

| 2 |

+

"<|box_end|>": 151649,

|

| 3 |

+

"<|box_start|>": 151648,

|

| 4 |

+

"<|endoftext|>": 151643,

|

| 5 |

+

"<|im_end|>": 151645,

|

| 6 |

+

"<|im_start|>": 151644,

|

| 7 |

+

"<|image_pad|>": 151655,

|

| 8 |

+

"<|object_ref_end|>": 151647,

|

| 9 |

+

"<|object_ref_start|>": 151646,

|

| 10 |

+

"<|quad_end|>": 151651,

|

| 11 |

+

"<|quad_start|>": 151650,

|

| 12 |

+

"<|video_pad|>": 151656,

|

| 13 |

+

"<|vision_end|>": 151653,

|

| 14 |

+

"<|vision_pad|>": 151654,

|

| 15 |

+

"<|vision_start|>": 151652

|

| 16 |

+

}

|

chat_template.json

ADDED

|

@@ -0,0 +1,3 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1 |

+

{

|

| 2 |

+

"chat_template": "{% set image_count = namespace(value=0) %}{% set video_count = namespace(value=0) %}{% for message in messages %}{% if loop.first and message['role'] != 'system' %}<|im_start|>system\nYou are a helpful assistant.<|im_end|>\n{% endif %}<|im_start|>{{ message['role'] }}\n{% if message['content'] is string %}{{ message['content'] }}<|im_end|>\n{% else %}{% for content in message['content'] %}{% if content['type'] == 'image' or 'image' in content or 'image_url' in content %}{% set image_count.value = image_count.value + 1 %}{% if add_vision_id %}Picture {{ image_count.value }}: {% endif %}<|vision_start|><|image_pad|><|vision_end|>{% elif content['type'] == 'video' or 'video' in content %}{% set video_count.value = video_count.value + 1 %}{% if add_vision_id %}Video {{ video_count.value }}: {% endif %}<|vision_start|><|video_pad|><|vision_end|>{% elif 'text' in content %}{{ content['text'] }}{% endif %}{% endfor %}<|im_end|>\n{% endif %}{% endfor %}{% if add_generation_prompt %}<|im_start|>assistant\n{% endif %}"

|

| 3 |

+

}

|

config.json

ADDED

|

@@ -0,0 +1,48 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1 |

+

{

|

| 2 |

+

"_attn_implementation_autoset": true,

|

| 3 |

+

"_name_or_path": "EraX-VL-7B-V1.5",

|

| 4 |

+

"architectures": [

|

| 5 |

+

"Qwen2VLForConditionalGeneration"

|

| 6 |

+

],

|

| 7 |

+

"attention_dropout": 0.0,

|

| 8 |

+

"bos_token_id": 151643,

|

| 9 |

+

"eos_token_id": 151645,

|

| 10 |

+

"hidden_act": "silu",

|

| 11 |

+

"hidden_size": 3584,

|

| 12 |

+

"image_token_id": 151655,

|

| 13 |

+

"initializer_range": 0.02,

|

| 14 |

+

"intermediate_size": 18944,

|

| 15 |

+

"max_position_embeddings": 32768,

|

| 16 |

+

"max_window_layers": 28,

|

| 17 |

+

"model_type": "qwen2_vl",

|

| 18 |

+

"num_attention_heads": 28,

|

| 19 |

+

"num_hidden_layers": 28,

|

| 20 |

+

"num_key_value_heads": 4,

|

| 21 |

+

"rms_norm_eps": 1e-06,

|

| 22 |

+

"rope_scaling": {

|

| 23 |

+

"mrope_section": [

|

| 24 |

+

16,

|

| 25 |

+

24,

|

| 26 |

+

24

|

| 27 |

+

],

|

| 28 |

+

"rope_type": "default",

|

| 29 |

+

"type": "default"

|

| 30 |

+

},

|

| 31 |

+

"rope_theta": 1000000.0,

|

| 32 |

+

"sliding_window": 32768,

|

| 33 |

+

"tie_word_embeddings": false,

|

| 34 |

+

"torch_dtype": "bfloat16",

|

| 35 |

+

"transformers_version": "4.47.1",

|

| 36 |

+

"use_cache": true,

|

| 37 |

+

"use_sliding_window": false,

|

| 38 |

+

"video_token_id": 151656,

|

| 39 |

+

"vision_config": {

|

| 40 |

+

"in_chans": 3,

|

| 41 |

+

"model_type": "qwen2_vl",

|

| 42 |

+

"spatial_patch_size": 14

|

| 43 |

+

},

|

| 44 |

+

"vision_end_token_id": 151653,

|

| 45 |

+

"vision_start_token_id": 151652,

|

| 46 |

+

"vision_token_id": 151654,

|

| 47 |

+

"vocab_size": 152064

|

| 48 |

+

}

|

generation_config.json

ADDED

|

@@ -0,0 +1,14 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1 |

+

{

|

| 2 |

+

"attn_implementation": "flash_attention_2",

|

| 3 |

+

"bos_token_id": 151643,

|

| 4 |

+

"do_sample": true,

|

| 5 |

+

"eos_token_id": [

|

| 6 |

+

151645,

|

| 7 |

+

151643

|

| 8 |

+

],

|

| 9 |

+

"pad_token_id": 151643,

|

| 10 |

+

"temperature": 0.01,

|

| 11 |

+

"top_k": 1,

|

| 12 |

+

"top_p": 0.001,

|

| 13 |

+

"transformers_version": "4.47.0.dev0"

|

| 14 |

+

}

|

images/27vid-Gaza-City-Cover-gqmt-videoSixteenByNine1050 (1).jpg

ADDED

.jpg)

|

images/nguyentonnhuan.jpg

ADDED

|

images/nguyenvandung_back.png

ADDED

|

images/nguyenvandung_front.png

ADDED

|

images/test.txt

ADDED

|

File without changes

|

images/trinhquangduy_back.jpg

ADDED

|

images/trinhquangduy_front.jpg

ADDED

|

merges.txt

ADDED

|

The diff for this file is too large to render.

See raw diff

|

|

|

openvino_language_model.bin

ADDED

|

@@ -0,0 +1,3 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1 |

+

version https://git-lfs.github.com/spec/v1

|

| 2 |

+

oid sha256:bcd30330595dccf86956386c695929ea329c110269d94b369c20ecae2f0fbe50

|

| 3 |

+

size 3936211968

|

openvino_language_model.xml

ADDED

|

The diff for this file is too large to render.

See raw diff

|

|

|

openvino_text_embeddings_model.bin

ADDED

|

@@ -0,0 +1,3 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1 |

+

version https://git-lfs.github.com/spec/v1

|

| 2 |

+

oid sha256:9ddd207deedbbafaa2e15c910325fbbb1658491246ec356b9dd33593457e9b2e

|

| 3 |

+

size 1089994756

|

openvino_text_embeddings_model.xml

ADDED

|

@@ -0,0 +1,107 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1 |

+

<?xml version="1.0"?>

|

| 2 |

+

<net name="Model0" version="11">

|

| 3 |

+

<layers>

|

| 4 |

+

<layer id="0" name="input" type="Parameter" version="opset1">

|

| 5 |

+

<data shape="?,?" element_type="i64" />

|

| 6 |

+

<output>

|

| 7 |

+

<port id="0" precision="I64" names="input">

|

| 8 |

+

<dim>-1</dim>

|

| 9 |

+

<dim>-1</dim>

|

| 10 |

+

</port>

|

| 11 |

+

</output>

|

| 12 |

+

</layer>

|

| 13 |

+

<layer id="1" name="self.weight" type="Const" version="opset1">

|

| 14 |

+

<data element_type="bf16" shape="152064, 3584" offset="0" size="1089994752" />

|

| 15 |

+

<output>

|

| 16 |

+

<port id="0" precision="BF16" names="self.weight">

|

| 17 |

+

<dim>152064</dim>

|

| 18 |

+

<dim>3584</dim>

|

| 19 |

+

</port>

|

| 20 |

+

</output>

|

| 21 |

+

</layer>

|

| 22 |

+

<layer id="2" name="ov_ext::embedding/Convert" type="Convert" version="opset1">

|

| 23 |

+

<data destination_type="f32" />

|

| 24 |

+

<rt_info>

|

| 25 |

+

<attribute name="decompression" version="0" />

|

| 26 |

+

</rt_info>

|

| 27 |

+

<input>

|

| 28 |

+

<port id="0" precision="BF16">

|

| 29 |

+

<dim>152064</dim>

|

| 30 |

+

<dim>3584</dim>

|

| 31 |

+

</port>

|

| 32 |

+

</input>

|

| 33 |

+

<output>

|

| 34 |

+

<port id="1" precision="FP32">

|

| 35 |

+

<dim>152064</dim>

|

| 36 |

+

<dim>3584</dim>

|

| 37 |

+

</port>

|

| 38 |

+

</output>

|

| 39 |

+

</layer>

|

| 40 |

+

<layer id="3" name="ov_ext::embedding/Convert_1" type="Convert" version="opset1">

|

| 41 |

+

<data destination_type="i32" />

|

| 42 |

+

<input>

|

| 43 |

+

<port id="0" precision="I64">

|

| 44 |

+

<dim>-1</dim>

|

| 45 |

+

<dim>-1</dim>

|

| 46 |

+

</port>

|

| 47 |

+

</input>

|

| 48 |

+

<output>

|

| 49 |

+

<port id="1" precision="I32">

|

| 50 |

+

<dim>-1</dim>

|

| 51 |

+

<dim>-1</dim>

|

| 52 |

+

</port>

|

| 53 |

+

</output>

|

| 54 |

+

</layer>

|

| 55 |

+

<layer id="4" name="ov_ext::embedding/Constant" type="Const" version="opset1">

|

| 56 |

+

<data element_type="i32" shape="" offset="1089994752" size="4" />

|

| 57 |

+

<output>

|

| 58 |

+

<port id="0" precision="I32" />

|

| 59 |

+

</output>

|

| 60 |

+

</layer>

|

| 61 |

+

<layer id="5" name="ov_ext::embedding/Gather" type="Gather" version="opset8">

|

| 62 |

+

<data batch_dims="0" />

|

| 63 |

+

<input>

|

| 64 |

+

<port id="0" precision="FP32">

|

| 65 |

+

<dim>152064</dim>

|

| 66 |

+

<dim>3584</dim>

|

| 67 |

+

</port>

|

| 68 |

+

<port id="1" precision="I32">

|

| 69 |

+

<dim>-1</dim>

|

| 70 |

+

<dim>-1</dim>

|

| 71 |

+

</port>

|

| 72 |

+

<port id="2" precision="I32" />

|

| 73 |

+

</input>

|

| 74 |

+

<output>

|

| 75 |

+

<port id="3" precision="FP32">

|

| 76 |

+

<dim>-1</dim>

|

| 77 |

+

<dim>-1</dim>

|

| 78 |

+

<dim>3584</dim>

|

| 79 |

+

</port>

|

| 80 |

+

</output>

|

| 81 |

+

</layer>

|

| 82 |

+

<layer id="6" name="Result_9" type="Result" version="opset1">

|

| 83 |

+

<input>

|

| 84 |

+

<port id="0" precision="FP32">

|

| 85 |

+

<dim>-1</dim>

|

| 86 |

+

<dim>-1</dim>

|

| 87 |

+

<dim>3584</dim>

|

| 88 |

+

</port>

|

| 89 |

+

</input>

|

| 90 |

+

</layer>

|

| 91 |

+

</layers>

|

| 92 |

+

<edges>

|

| 93 |

+

<edge from-layer="0" from-port="0" to-layer="3" to-port="0" />

|

| 94 |

+

<edge from-layer="1" from-port="0" to-layer="2" to-port="0" />

|

| 95 |

+

<edge from-layer="2" from-port="1" to-layer="5" to-port="0" />

|

| 96 |

+

<edge from-layer="3" from-port="1" to-layer="5" to-port="1" />

|

| 97 |

+

<edge from-layer="4" from-port="0" to-layer="5" to-port="2" />

|

| 98 |

+

<edge from-layer="5" from-port="3" to-layer="6" to-port="0" />

|

| 99 |

+

</edges>

|

| 100 |

+

<rt_info>

|

| 101 |

+

<Runtime_version value="2024.6.0-17404-4c0f47d2335-releases/2024/6" />

|

| 102 |

+

<conversion_parameters>

|

| 103 |

+

<framework value="pytorch" />

|

| 104 |

+

<is_python_object value="True" />

|

| 105 |

+

</conversion_parameters>

|

| 106 |

+

</rt_info>

|

| 107 |

+

</net>

|

openvino_vision_embeddings_merger_model.bin

ADDED

|

@@ -0,0 +1,3 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1 |

+

version https://git-lfs.github.com/spec/v1

|

| 2 |

+

oid sha256:708721814872d85ce7faf6e2ac54b3d0225c029a5293704a84602e352c4943e3

|

| 3 |

+

size 359928592

|

openvino_vision_embeddings_merger_model.xml

ADDED

|

The diff for this file is too large to render.

See raw diff

|

|

|

openvino_vision_embeddings_model.bin

ADDED

|

@@ -0,0 +1,3 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1 |

+

version https://git-lfs.github.com/spec/v1

|

| 2 |

+

oid sha256:85a63e6b6f0f4755f31e9c05cd97299215cb157882242dc3683781cd9f3349d4

|

| 3 |

+

size 3010616

|

openvino_vision_embeddings_model.xml

ADDED

|

@@ -0,0 +1,167 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|